Together发布首个全面开源社区版ChatGPT(含权重与训练数据集)

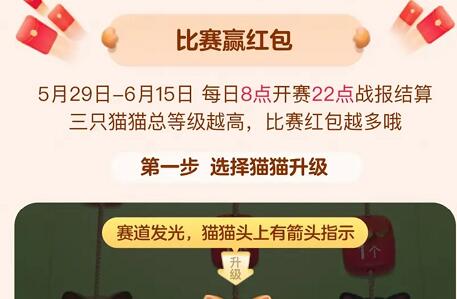

淘宝搜:【红包到手500】领超级红包,京东搜:【红包到手500】

淘宝互助,淘宝双11微信互助群关注公众号 【淘姐妹】

本周带来的?10?个?SOTA?模型分别用于聊天对话、视觉语言、具身任务如机器人操作、语音识别、视觉表征等;还有?2 个工具用于上下文学习、聊天机器人构建。

Together联手LAION及Ontocord发布首个全面开源社区版ChatGPT

Together团队发布OpenChatKit,这是一个强大的聊天应用开发工具,相关的代码,模型细节权重和训练数据集均已开源,支持开发特定领域和通用的聊天机器人。训练数据集由Together 团队与 LAION 和 Ontocord 合作共同构建。OpenChatKit 的聊天模型支持推理、多轮对话和生成答案,该模型拥有 200 亿个参数并接受了 4300 万条指令的训练。OpenChatKit 包括一个通用聊天机器人和创建专用机器人所需的组件,主要这四部分:一个指令微调的 200 亿参数语言模型(GPT-NeoX-20B)、一个 60 亿参数调节模型(GPT-JT-6B)和一个可扩展的检索系统,以及一组用于微调模型以实现高精度的定制用户任务的方案。

获取资源:

https://sota.ji【【微信】】.com/project/openchatkit

微软开源【【微信】】,在聊天中实现对话问答、看图问答、AI画图/改图

【【微信】】: Talking, Drawing and Editing with 【【微信】】ls

ChatGPT 在许多领域展现出卓越的对话和推理能力。然而,由于 ChatGPT 是用语言进行训练的,因此它目前无法处理或生成来自视觉世界的图像。该研究开源 【【微信】】 ,用 ChatGPT api 和开源视觉基础模型构建的多模态问答系统,可在聊天中实现对话问答、看图问答、AI画图/改图。

获取资源:

https://sota.ji【【微信】】.com/project/visual-chatgpt

英伟达提出视觉语言模型Prismer,利用领域专家高效实现视觉语言推理任务

Prismer: A 【【微信】】 with An Ensemble of Experts

最近视觉语言模型展示了高超的多模态生成能力,但通常需要在大规模数据集上训练庞大的模型。为了更具可扩展性,该研究引入了 Prismer,利用领域专家(domain experts)集合构建的数据和参数高效的视觉语言模型。Prismer 仅需要训练少量组件,大多数网络权重来自预训练领域专家,并在训练期间保持冻结。Prismer 在微调和少试学习条件下,视觉语言推理性能与当前最先进技术相媲美,同时训练数据减少两个数量级。

获取资源:

https://sota.ji【【微信】】.com/project/prismer

谷歌提出PaLM-E,将现实世界的连续传感器模态纳入语言模型,实现多模态感知和联想

PaLM-E: An Embodied Multimodal Language Model

大型语言模型要在现实世界中实现普适推理(例如,用于机器人问题)需要克服“接地”问题。该研究提出具身多模态模型?PaLM-E,将真实世界中的连续感知模态直接融入语言模型,建立单词和感知之间的联系。其输入为多模态语句,其中交错了视觉、连续状态估计和文本输入编码。将这些编码与预训练大型语言模型一起进行端到端训练,可用于多个具体任务,包括顺序序列机器人操作规划、视觉问答和字幕生成,这受益于互联网规模的语言、视觉和视觉语言领域的多样化联合训练。

获取资源:

https://sota.ji【【微信】】.com/project/palm-e

上海人工智能实验室开源OpenICL,简化ICL模型的实现

OpenICL: An Open-Source Framework for In-context Learning

近年来,上下文学习(In-context Learning,ICL)作为大型语言模型(LLM)评估的新范式备受关注。与传统的微调方法不同,ICL 无需任何参数更新即可将预训练模型适应于未见任务。然而,由于涉及不同的检索和推理方法以及不同模型、数据集和任务的不同预处理要求,ICL 的实现是复杂的。该研究开源 OpenICL,这是一个用于 ICL 和 LLM 评估的开源工具包,具有高度灵活的架构,可以轻松组合不同的组件以适应用户的需求。OpenICL 还提供各种最先进的检索和推理方法,以简化将 ICL 适应最新研究的过程。

获取资源:

https://sota.ji【【微信】】.com/project/openicl

谷歌提出通用语音模型USM,将自动语音识别扩展到超过100种语言

Google USM: Scaling Automatic Speech Recognition Beyond 100 Languages

该研究介绍了通用语音模型(USM),可在100多种语言中进行自动语音识别(ASR),其在一个跨越 300 多种语言的 1200万(M)小时的大型无标签多语言数据集上对模型的编码器进行预训练,并在一个较小的有标签数据集上进行微调而实现。该模型在下游的多语言 ASR 和语音-文本翻译任务中取得最先进的性能,尽管使用的标记训练集的规模是 Whisper 模型的1/7,但该模型在许多语言的域内和域外语音识别任务中都表现出相当甚至更好的性能。

获取资源:

https://sota.ji【【微信】】.com/project/usm

特拉维夫大学提出面向语义字体设计的Word-as-image生成模型

Word-As-Image for Semantic Typography

Word-as-image 是一种面向语义字体设计的技术,可以在保持词可读性的同时,用文字插图可视化词,以在视觉上传达文字含义。该研究提出一种自动创建 "Word-as-image"插图的方法,依靠大型预训练语言视觉模型,从视觉上提炼出文本概念,并在预训练稳定扩散模型指导下,优化每个字母的轮廓。该方法可以处理大量的语义概念,在众多示例中展示了出色的视觉效果。

获取资源:

https://sota.ji【【微信】】.com/project/word-as-image

东北大学等提出COCs,基于无卷积和无注意力的新型视觉特征提取范式

Image as Set of Points

卷积网络将图像视为矩形中有组织的像素,并通过局部区域的卷积操作提取特征;视觉Transformers(ViTs)将图像视为补丁序列,并通过全局范围的注意机制提取特征。该研究提出新的视觉表示范式 Context Cluster(CoCs) ,其将图像视为一组无组织的点,并通过简化的聚类算法提取特征,在一些基准上取得了与 ConvNets 或 ViTs 相当甚至更好的结果,这为图像和视觉表征提供一个新的视角。

获取资源:

https://sota.ji【【微信】】.com/project/cocs

清华大学等提出VPD,将预训练文本图像扩散模型的高级知识迁移到下游任务中

Unleashing Text-to-Image Diffusion Models for 【【微信】】

该研究提出 VPD(预训练扩散模型的视觉感知),这是一种在视觉感知任务中利用预训练文本到图像扩散模型的语义信息的新框架。VPD 利用视觉特征和文本特征之间的交叉注意力图来提供明确的指导,与基于各种视觉预训练范式的方法相比,更好地适应下游视觉感知任务,实现了更快的收敛;在语义分割、参考图像分割和深度估计方面的大量实验证明了 VPD 的有效性,VPD 在 NYUv2 深度估计上达到了 0.254 的 RMSE,在 RefCOCO-val 参考图像分割上达到了 73.3% 的 oIoU。

获取资源:

https://sota.ji【【微信】】.com/project/vpd

OpenAI推出新的生成模型家族Consistency Models,无需对抗训练即可实现高样本质量

Consistency Models

扩散模型在图像、音频和视频生成方面取得了重大突破,但它们依赖于一个迭代的生成过程,导致采样速度缓慢,这限制了它们在实时应用方面的潜力。为了克服这一限制,该研究提出了Consistency Models,无需对抗性训练就能实现高采样质量。在设计上支持快速的单步生成,同时仍然允许几步取样来换取计算和样本质量;此外,还支持零试的图像编辑,如图像上色和超级分辨率,而无需对这些任务进行训练。

获取资源:

https://sota.ji【【微信】】.com/project/consistency-models

微软提出【【微信】】,将源语言语音作为提示,即可生成目标语言的高质量语音

Speak Foreign Languages with Your Own Voice: 【【微信】】odec Language Modeling

该研究提出了一种跨语言神经编解码语言模型 【【微信】】,用于跨语言语音合成。该模型通过使用源语言语音和目标语言文本作为提示,扩展了 VALL-E 并训练了一个多语言条件编解码语言模型来预测目标语音的声学令牌序列。实验结果表明,【【微信】】 可以仅通过一次源语言语音作为提示,在目标语言中生成高质量的语音,并保留未见过的说话者的声音、情感和声学环境。此外,【【微信】】 有效缓解了外语口音问题,并可以通过语言 ID 进行控制。

获取资源:

https://sota.ji【【微信】】.com/project/vall-e-x

谷歌等提出【【微信】】,由局部神经场组成,实现高效、结构感知的3D场景表示

【【微信】】: Local Radiance Fields for Efficient Structure-Aware 3D Scene Representation from 2D Supervisio

该研究提出 【【微信】】,一种新型 3D 场景表示方法,将场景分解成一组本地神经辐射场。通过仅利用光度和推断的全景图像监督,可以直接共同优化一组 【【微信】】 的参数,从而形成场景的分解表示,其中每个对象实例由一组 【【微信】】 表示。实验结果表明,【【微信】】:(1)比传统的全局 NeRF 更有效地逼近场景,(2)允许从任意视角提取全景和光度渲染,(3)支持 NeRF 不具备的任务,如 3D 全景分割和交互式编辑。该研究发现,每个 Nerflet 的局部性使得模型紧凑、高效且多视角一致。

获取资源:

https://sota.ji【【微信】】.com/project/nerflets

网页端访问: 在浏览器地址栏输入新版站点地址 sota.ji【【微信】】.com ,即可前往「SOTA!模型」平台,查看关注的模型是否有新资源收录。?

移动端访问:在微信移动端中搜索服务号名称「机器之心SOTA模型」或 ID 「sotaai」,关注 SOTA!模型服务号,即可通过服务号底部菜单栏使用平台功能,更有最新AI技术、开发资源及社区动态定期推送。

OpenAI宣布与支付公司Stripe合作:尝试将ChatGPT商业化

openai是哪个公司的,openai和chatGPT什么关系,openai账号注册,openai百度百科毫无疑问,OpenAI推出的ChatGPT,以及其背后的GPT人工智能模型,绝对称得上是一次相当瞩目的技术突破。

但与所有的人工智能一样,在最新的GPT-4背后的,依旧是庞大的研发与训练成本,这也促使OpenAI与微软都在积极尝试将产品商业化。

近日,OpenAI宣布将与支付公司Stripe合作,后者将为ChatGPT提供支付和订阅服务。

事实上,在OpenAI发布GPT-4后,官方就表示Stripe推出基于该模型的支付提供计费和结账功能,以及自动化和税务合规技术。

这次合作也意味着Stripe将把OpenAI的新技术整合到自己的产品和服务中,目前Stripe正在对14个GPT基础设施进行试验。

此次合作,能够解决OpenAI长期存在的大额资金需求,也能够缓解Stripe在融资中越来越低的估值,称得上是一次双赢。